Alors comme ça, vous avez une idée qui vous trotte dans la tête, mais vous hésitez sur l'outil qui va vous aider à la transformer en projet concret ? C'est le grand match du moment : Gemini vs ChatGPT. On a l'impression que le destin de notre business en dépend.

Imaginez que vous deviez recruter votre tout premier stagiaire. L'un est un créatif de génie, un poète qui peut vous écrire une page de vente qui donne des frissons. L'autre est un chercheur ultra-méticuleux, branché 24/7 sur Internet, qui vous trouve n'importe quelle info en 3 secondes.

Lequel choisissez-vous ? La vraie question, c'est : pour quelle mission ?

Allez, on se prend un café virtuel. Je vais vous montrer, sans jargon ni bla-bla, comment ces deux cerveaux artificiels peuvent devenir vos meilleurs coéquipiers. On va décortiquer ça ensemble, avec des exemples si simples que vous aurez envie de tester tout de suite.

Lequel choisir en 30 secondes chrono ?

Pas le temps ? Pas de problème. Voici le résumé express pour savoir qui appeler à la rescousse.

| Votre mission du jour | Votre copilote idéal | Pourquoi, en clair ? |

|---|---|---|

| Écrire des textes qui vendent, créer, trouver des idées folles | ChatGPT | C'est l'artiste. Il a le sens de la formule, il sait raconter une histoire et trouver les mots qui touchent. |

| Analyser le marché, trouver des infos fiables, faire une recherche | Gemini | C'est l'analyste. Connecté en direct à Internet, il vous donne des données fraîches et vérifiées. Parfait pour la stratégie. |

| Automatiser vos tâches dans Gmail, Docs, Sheets… | Gemini | C'est le local de l'étape. Intégré à Google, il transforme votre façon de travailler si vous utilisez déjà ces outils. |

L'objectif ? Que vous ne perdiez plus une minute à hésiter. À la fin de cet article, vous saurez exactement qui appeler pour quelle tâche.

Prêt à rencontrer votre futur bras droit digital ? C'est parti !

Gemini vs ChatGPT : Présentation des deux champions sur le ring

Avant de les voir en action, faisons rapidement connaissance. Imaginez deux experts prêts à bosser pour vous gratuitement. Lequel allez-vous briefer en premier ?

ChatGPT, le virtuose des mots

D'un côté, il y a ChatGPT, la rockstar créée par OpenAI. Lui, c'est le créatif de la bande. Vous lui donnez une idée brute, il vous en fait une histoire captivante.

Imaginez : il est minuit, vous avez une idée de business, mais pas le courage d’écrire la page d’accueil. ChatGPT, c’est comme un cofondateur invisible qui prend le relais. Il peut adopter un ton drôle, sérieux, inspirant… Bref, il donne une âme à vos textes. C'est l'outil parfait pour ne plus jamais angoisser devant une page blanche.

Gemini, l'expert de la donnée en temps réel

De l'autre côté, on a Gemini, le champion de Google. Lui, c'est votre analyste personnel. Son super-pouvoir ? Il est branché en direct sur tout le savoir d'Internet.

Si vous avez besoin de savoir quelles sont les dernières tendances sur votre marché, de vérifier une information ou de faire une synthèse sur un sujet complexe, c'est lui qu'il faut appeler. Sa force, c'est la précision et l'accès à l'info la plus fraîche. Il est hyper factuel, droit au but.

L'un est un conteur, l'autre est un détective. C'est la différence fondamentale qui va guider tous vos choix.

Maintenant que le décor est planté, voyons ce qu'ils ont vraiment dans le ventre.

Analyse comparative : On les met au défi sur des cas concrets

Fini la théorie, place à l'action. On va mettre ces deux IA au défi sur des missions que vous connaissez par cœur.

L'idée ? Vous montrer exactement quand l'un surpasse l'autre, pour que vous ne perdiez plus jamais de temps.

Créativité pure contre recherche factuelle

Imaginez que vous vouliez lancer une newsletter sur l'investissement pour les débutants. Il vous faut des idées, et vite.

- Votre demande à ChatGPT : « Sors-moi 10 idées de sujets de newsletter complètement dingues et contre-intuitives sur l'investissement pour les nuls. Je veux surprendre mes lecteurs ! »

- Votre demande à Gemini : « Liste-moi les 10 questions les plus posées sur Google en France ce mois-ci par les gens qui veulent commencer à investir. Transforme-les en titres de newsletter qui donnent envie de cliquer. »

Vous voyez la différence ? C'est énorme !

Avec ChatGPT, vous obtiendrez des concepts originaux, peut-être même un peu provocateurs. Parfait pour construire une marque unique.

Avec Gemini, vous aurez des sujets basés sur une demande réelle. Chaque titre répondra à une question que des milliers de gens se posent. C'est une stratégie SEO redoutable.

Le secret n'est pas de les opposer, mais de les faire bosser ensemble. Pensez-y comme à un duo d'experts dans votre équipe, pas à un combat à mort.

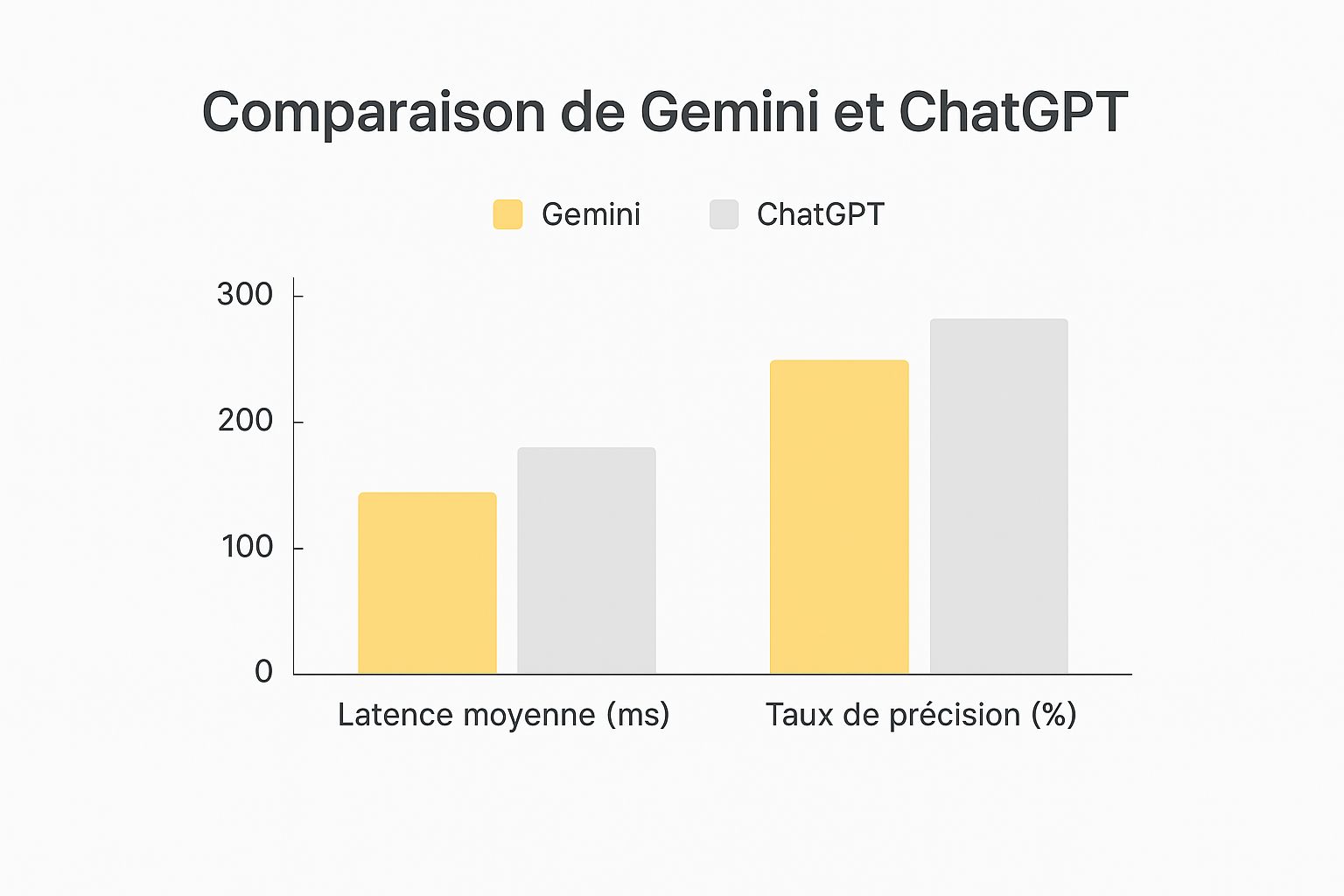

Ce graphique le montre bien : Gemini mise tout sur la fiabilité de l'information. ChatGPT, lui, est un champion de la vitesse, parfait pour un brainstorming où l'on veut que les idées fusent sans filtre.

Bien sûr, il existe d'autres outils qui tentent de combiner les deux. Si ça vous intrigue, vous pouvez explorer des alternatives gratuites à ChatGPT et Gemini pour avoir une vision plus large.

Mais pour l'instant, posez-vous cette simple question : "Là, maintenant, j'ai besoin d'un artiste ou d'un analyste ?". Votre réponse vous donnera le nom de votre meilleur copilote.

L'IA sur le terrain : Mises en situation pour entrepreneurs et créateurs

Ok, mais concrètement, comment ça peut vous faire gagner du temps aujourd'hui ? Plongeons dans votre quotidien.

Il est 23h. Vous devez préparer votre post Instagram pour demain matin, mais l'inspiration est partie se coucher. Le curseur clignote, l'angoisse monte… C'est là que votre copilote IA débarque.

Scénario 1 : Votre script YouTube, prêt en 10 minutes

Votre objectif : créer une vidéo sur les dernières tendances pour lancer un business en ligne.

- Étape 1 : Mission pour Gemini : « Trouve-moi les 5 tendances business en ligne qui explosent sur le web cette semaine. Sors-moi des chiffres, des sources, des exemples concrets. Propose-moi un plan en 3 parties pour une vidéo de 5 minutes. »

- Étape 2 : Mission pour ChatGPT : « J'ai ce plan [collez le plan de Gemini]. Transforme-le en un script YouTube super dynamique. Je veux une intro qui choque, des exemples qui parlent à tout le monde et un appel à l'action qui donne envie de s'abonner. Le ton : un ami qui donne ses meilleurs secrets. »

Vous voyez la puissance du duo ? Gemini fait le travail de recherche chiant et fastidieux. Ensuite, ChatGPT prend le relais et transforme ces données brutes en un contenu qui va scotcher votre audience.

Le débat Gemini vs ChatGPT est terminé. La vraie question, c'est : comment les faire collaborer ?

Scénario 2 : La description produit qui fait vendre

Autre cas. Vous vendez un café en grains "extra-énergisant" sur votre site. Il faut une description qui donne envie de l'acheter maintenant.

Le défi : Écrire 100 mots qui décrivent son goût intense, son origine éthique et son effet "coup de boost". Le ton : motivant et un peu décalé.

Ici, ChatGPT est un monstre. Il ne va pas juste lister les caractéristiques. Il va vous raconter l'histoire du café qui transforme votre lundi matin en une journée de conquête.

Pourtant, Gemini n'est pas loin derrière. Avec 35 millions d'utilisateurs actifs chaque jour, il rattrape son retard à une vitesse folle, surtout grâce à son intégration dans l'écosystème Google. Jetez un œil à cette croissance spectaculaire de Gemini, c'est bluffant.

Pour le storytelling pur, ChatGPT a souvent un léger avantage. Mais attendez de voir comment Gemini peut analyser les descriptions de vos concurrents pour trouver leurs faiblesses…

ChatGPT, votre étincelle créative

Parlons un peu de la star ChatGPT. Si vous avez l'impression qu'on ne parle que de lui, c'est normal. C'est le partenaire créatif rêvé : il n'est jamais fatigué, jamais à court d'idées.

Il est 2h du matin, une idée de slogan vous réveille. Au lieu de la noter sur un post-it, vous la donnez à ChatGPT. 10 secondes plus tard, il vous propose 5 versions améliorées, prêtes à être utilisées. Ça, c'est de la magie.

Comment en faire votre meilleur allié pour créer ?

Pensez à lui comme à un sparring-partner. Plus vous le challengez, meilleur il devient.

- Pour vos brainstormings : Lancez-lui un défi comme : "Donne-moi 10 noms pour ma nouvelle marque de bougies artisanales. Je veux que ça sonne à la fois chic et un peu rebelle." Vous serez bluffé.

- Pour trouver le ton juste : Donnez-lui un de vos textes et demandez : "Réécris ça comme si tu parlais à un ami autour d'un verre." C'est un exercice génial pour trouver votre voix.

- Pour tout le reste : Il peut vous rédiger un email de prospection, un tweet, une légende Instagram, le script d'une story…

Son succès est dingue. Lancé en novembre 2022, ChatGPT est utilisé par près de 700 millions de personnes chaque semaine. Les chiffres sur cette adoption massive de ChatGPT en France et dans le monde donnent le tournis.

Attention, petit piège : La version gratuite de ChatGPT n'est pas connectée à Internet en temps réel. Parfois, il peut "halluciner", c'est-à-dire inventer des infos avec un aplomb total.

Utilisez-le comme un tremplin créatif, mais gardez toujours un œil critique. C'est votre super-pouvoir, c'est vous le boss !

Alors, comment choisir votre copilote IA idéal ?

Après ce duel, qui gagne ? Gemini ou ChatGPT ? La réponse va peut-être vous surprendre : ni l'un ni l'autre. Le grand gagnant, c'est vous. Le meilleur outil est celui qui colle parfaitement à votre mission du moment.

Pour faire simple, retenez cette règle d'or :

Besoin d'un artiste ? Appelez ChatGPT. Pour tout ce qui est écriture, copywriting, storytelling, création de contenu… Il est imbattable pour donner une âme à vos idées et créer une connexion émotionnelle avec votre audience.

Besoin d'un analyste ? Appelez Gemini. Pour tout ce qui demande des faits, des chiffres, des données à jour. Recherche de marché, analyse de la concurrence, synthèse d'articles… Il est votre agent secret connecté au monde réel.

Le vrai secret : arrêtez de vouloir choisir

Les entrepreneurs les plus malins ne choisissent pas. Ils combinent. C'est là que la vraie magie opère.

Le plan d'action ultime :

- Vous lancez Gemini pour faire une analyse de marché sur vos concurrents et trouver les 3 angles d'attaque qu'ils n'utilisent pas.

- Vous prenez ces 3 angles, vous les donnez à ChatGPT et vous lui demandez de vous écrire 3 pubs Facebook irrésistibles.

Voilà. En 15 minutes, vous avez fait un travail qui vous aurait pris des jours. L'IA est un levier. Votre génie, c'est de savoir lequel actionner au bon moment. C'est une logique qui s'applique à tous les outils, comme on l'explique dans notre comparatif détaillé entre ChatGPT, Jasper et Bard.

Alors, oubliez le "contre". Pensez "avec". Commencez à construire votre propre équipe d'assistants IA de choc.

Vos questions, nos réponses (sans détour)

On arrive au bout, et je parie que vous avez encore quelques questions qui tournent en boucle. C'est normal ! On va clarifier ça tout de suite pour que vous puissiez vous lancer sereinement.

Faut-il forcément payer pour utiliser Gemini ou ChatGPT ?

Absolument pas ! Et c'est la meilleure nouvelle de la journée. Les versions gratuites sont déjà des monstres de puissance. Vous pouvez écrire, créer, chercher, brainstormer… sans débourser un centime. C'est parfait pour démarrer et vous faire la main.

Les abonnements payants, c'est comme passer en mode "expert". C'est utile quand vous utilisez l'IA tous les jours et que vous voulez accéder aux toutes dernières fonctionnalités. Mais commencez par le gratuit, c'est déjà énorme.

Lequel est le meilleur pour le SEO (référencement Google) ?

Ah, la question à un million ! Ma réponse : les deux, mon capitaine ! Mais pas pour la même chose.

- Commencez avec Gemini pour la stratégie. Demandez-lui : "Quels sont les mots-clés que mes concurrents oublient ? Sur quels sujets je peux me positionner ?". Sa connexion à Google en fait un espion redoutable.

- Enchaînez avec ChatGPT pour la création. Une fois que vous avez vos mots-clés et vos sujets, demandez à ChatGPT : "Écris-moi un article de blog de 1500 mots sur ce sujet, optimisé pour ce mot-clé, avec un ton fun et des exemples concrets."

En résumé : Gemini trouve la pépite d'or, ChatGPT la transforme en bijou.

Est-ce que je peux vraiment lancer mon business juste avec ces outils ?

Oui. À 1000 %. Mais attention, ce ne sont pas des baguettes magiques. L'IA ne remplacera jamais votre vision, votre intuition et votre passion.

Voyez-les comme les meilleurs stagiaires du monde. Ils exécutent les tâches lourdes et répétitives à une vitesse folle. Ça vous libère un temps précieux pour vous concentrer sur ce que vous seul pouvez faire : la stratégie, la créativité, la relation avec vos clients. L'IA est le moteur, mais c'est toujours vous qui tenez le volant.

Prêt à passer de la curiosité à la création ? Chez Frank Houbre – IA & intelligence artificielle, notre mission est de vous donner les clés pour transformer vos idées en projets concrets. Découvrez nos formations conçues pour vous aider à maîtriser l'IA et enfin lancer l'aventure qui vous fait vibrer sur https://businessdynamite.xyz.